手軽にローカルで動かしつつ、 REST API も叩けるようにする方法まではあまり記事になっていないのでメモです。ご参考にされる場合は自己責任にて。

なぜ LM Studio なのか?

LM Studio は、ローカルで LLM を実行するアプリケーションです。セットアップが簡単な上、モデルHuggingは Hugging Face から直接ダウンロードも可能です。

REST API のサーバもワンクリックで起動でき、LLM をローカルで使いたい自前アプリ開発者にも魅力です。

LM Studio の特長

- GUI:CLI を介さず、モデルを指定すればChatGPTのようなチャット画面をすぐ出せる

- LLMのモデル:DeepSeek-R1 を含む多くのモデルに対応。Hugging Faceを検索しそのままダウンロードしてこれる

- GPU 最適化:CUDA 対応のマシンであれば自動で使用してくれる

LM Studio で DeepSeek-R1 を動かす手順

1. LM Studio のインストール

LM Studio は Windows、macOS、Linux に対応しています。

公式サイト(https://lmstudio.ai)から適切なバージョンをダウンロードし、インストールします。

2. DeepSeek-R1 のモデルをダウンロード

最初の画面で、モデルを何かダウンロードするよう促されます。そこで DeepSeek-R1 が出ていればそのままダウンロードしましょう。

Hugging Face Hub などのリポジトリからダウンロードも可能です。左側の虫眼鏡のアイコンの「Discover」から検索しましょう。

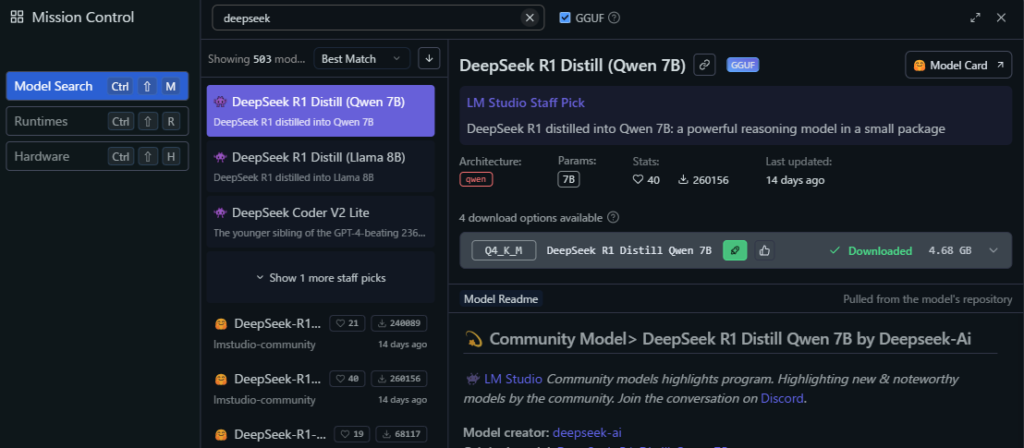

- 「Discover」 タブ の「Model Search」

- GGUFにチェックを入れ、モデルを検索

あるいは、Hugging Face に自分でアクセスし、手動でモデルを読ませることもできます。

- https://huggingface.co/ にアクセスし、モデルをダウンロードしておく

- 「My Models」タブを開く

- ディレクトリの指定画面で、「Models Directory」の部分でモデルが入っているディレクトリを指定する

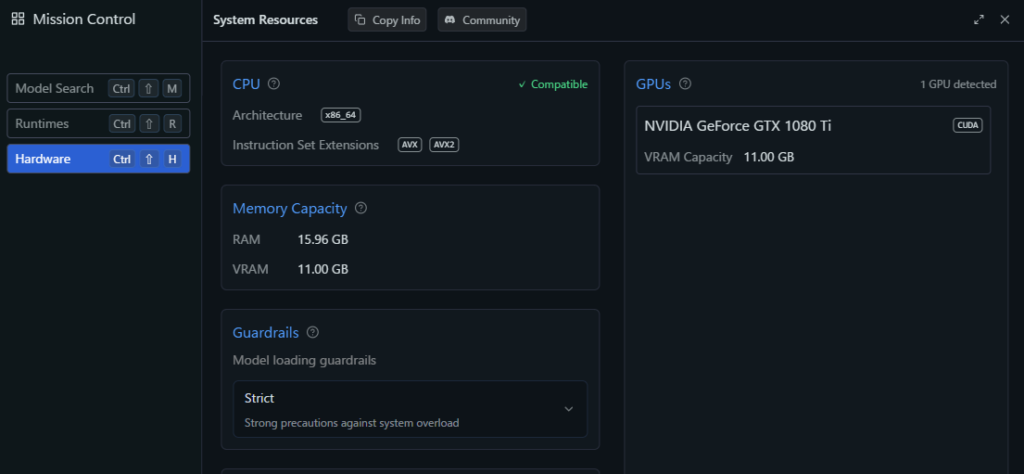

GPUは自動で使われる

GeForceが積まれていれば、基本的には何もしなくても自動でCUDAを介して使用されます。

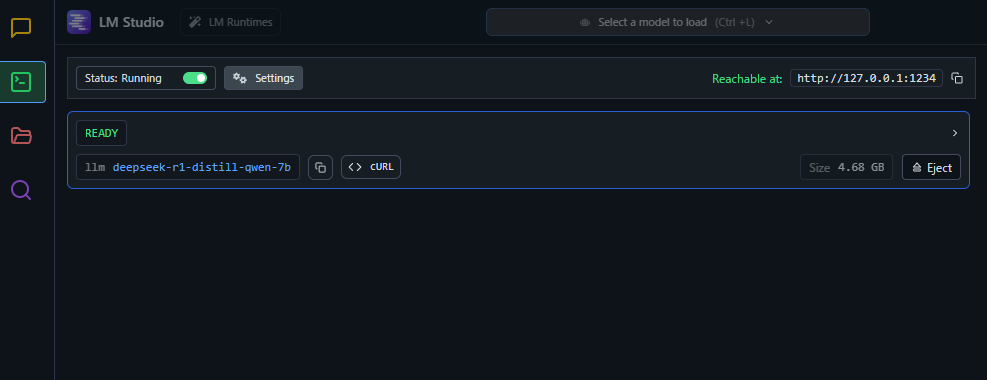

REST API を動かす

「Developer」のタブを開き、 「Status」のトグルをクリックすると REST API を提供するサーバが起動します。

あとは自由に叩くだけです。これは便利。

curl http://localhost:1234/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-r1-distill-qwen-7b",

"messages": [

{ "role": "system", "content": "○○○○○○" },

{ "role": "user", "content": "○○○○○○" }

],

"temperature": 0.5,

"max_tokens": -1,

"stream": false

}'楽になったものだ…